Az egész napos program nyitóelőadásában Körmendi György, a konferenciát szervező Clementine ügyvezetője beszélt a legújabb, a szakmát érintő kérdésekről. Egyre jobban teret nyer ugyanis a jog, vagy éppen az adatvédelem kérdése az adatbányászat területén, hiszen a „Kié az adat?” vagy éppen „Hogyan védhetjük meg az adatokat / kié a felelősség?” napi szinten felmerülő kérdések. Ráadásul a közelmúlt adatvédelmi botrányai (pl. Facebook), vagy a robotok egyre nagyobb elterjedése új helyzeteket teremt, amelyre a szakmának (is) mielőbbi válaszokkal kell szolgálni. Az előadás második felében Körmendi György bemutatta a Clementine virtuális asszisztens és chatbot megoldásait, melyek a gyakorlatban már több vállalat mindennapi munkáját könnyítik meg az ügyfélszolgálat vagy éppen az automata szövegfeldolgozás területén.

A dataSTREAM konferencia minden évben nagy hangsúlyt fektet arra, hogy az előadások mellett informális beszélgetésekre is lehetőséget adjon, ezáltal is biztosítva, hogy a jelenlévő szakemberek az iparág jelenét érintő kihívásokról és a várható jövőbeni trendekről is ütköztethessék véleményüket. 2018-ban hivatalos platformot biztosítottunk ezen témáknak, így egy kerekasztal beszélgetésen mondta el nézeteit három szakértő (Körmendi György, a Clementine ügyvezetője, Kovács Gyula, az Andego Kft. ügyvezető partnere és Dunai Albert, a Magyar Telekom senior data science szakértője), méghozzá Simon Krisztián, a Marketing és Média főszerkesztője, a Brandmania műsorvezetője irányításával.

A bemelegítő kérdések (Hol van az adatbányászat helye a szervezetekben?) után egyre mélyebb területeket érintve tudtuk meg a résztvevők véleményt a data science hatékonyságáról, folyamatairól, vagy éppen az üzleti hasznáról. Természetesen szóba kerültek a robotok, a jövő nagy áttörései vagy éppen a GDPR várható hatásai is.

A jó hangulatú, közel egy órás beszélgetésen komplex képet kaphattunk az adatbányászat jelenéről és jövőjéről, vállalati és elemzői oldalról is.

Dr. Reinhold Engelbrecht, az IBM Digital Business Automation európai szakértője a vállalat legújabb megoldását mutatta be. A Robotic Process Automation (RPA) egy olyan innovatív terület, mely segít a rutin feladatokat automatizálni, ezáltal időt és költséget takaríthatunk meg, miközben az emberi figyelmetlenségből adódó hibákat is elkerülhetjük. Előadásában az RPA fő előnyei mellett szó esett az IBM portfólióban található többi termékkel való kapcsolódásáról is, valamint gyakorlati példákon keresztül láthattuk ezen megoldás üzleti hasznait is.

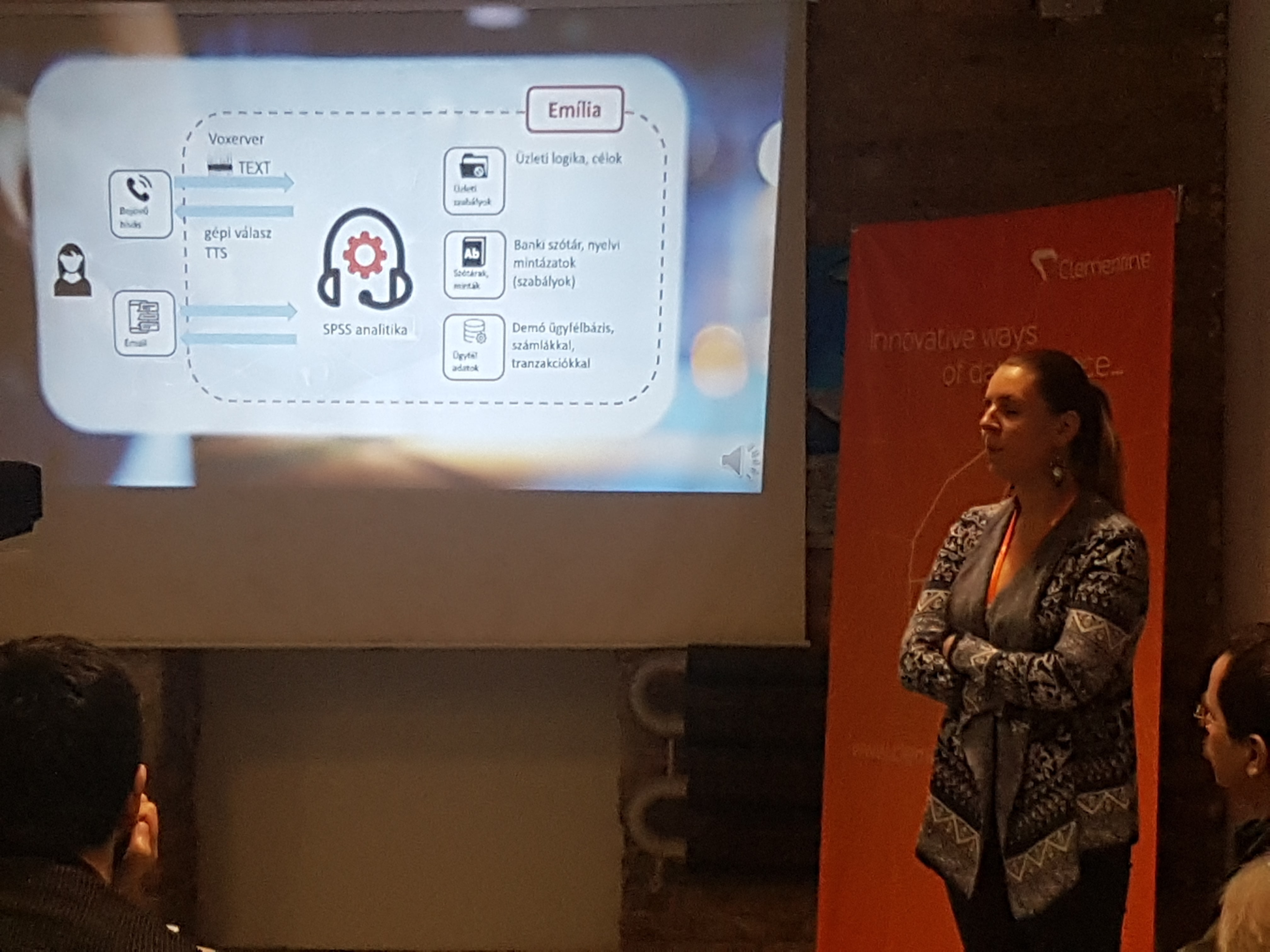

Körmendi György, a Clementine ügyvezetője „Hogy néz ki egy robotgyár?” című előadásában azokról a vállalati robotokról beszélt, amelyek megkönnyítik a mindennapi munkavégzést, növelik a folyamatok hatékonyságát. A Clementine virtuális asszisztenseinek segítségével az emberi rutinfeladatok automatizált megoldásokra cserélhetők. Az így kiváltott ismétlődő, manuális feladatok helyett az ügyfélszolgálati munkatársak az értékteremtő folyamatokra koncentrálhatnak. A cég fejlesztésében az RPA (Robotic Process Automation) folyamatba egy mesterséges intelligencia épül be a könnyebb döntések érdekében, így bizonyos ügyfél interakciókat kiindulásként kezelve ténylegesen végig lehet vinni egy-egy tranzakciót.

Hegedüs Pál, a Clementine vezető elemzője az IBM Watson Studio működését, üzleti problémákra adott megoldásait mutatta be. Az előadásban szó esett az integrált eszközökről (pl. SPSS Modeler, open source eszközök (python, R), döntésoptimalizációs algoritmusok, képfelismerő algoritmusok, deep learning stb.), valamint ezek vizualizációiról is. Az érdekes és hasznos előadás videós tartalmai a gyakorlati használatot is prezentálták, például az arcfelismerés vagy a Phyton alapú adatfeldolgozás területén.

Máté Anna és Mészáros Evelin, a Clementine elemzőiként a World Happiness felmérés adatait vizualizálták SPSS Modelerben, Python kódok használatával, de felhasználóbarát módon. A Python programozási nyelv egyre nagyobb elterjedése és az elérhető modulok sokszínűsége egyre jobban teret enged ugyanis a kreativitásnak: egyre dinamikusabb és sokrétűbb adatmegjelenítés lehetséges. Az így kialakult boldogságtérképeken különböző színek jelzik az intenzitást, így földrajzi helyekre vetítve megtudhattuk, hogy mely országok a legnagylelkűbbek, legtehetősebbek vagy épp legboldogabbak.

Molnár Sándor, az Ariosz energia üzletágvezetője a NatConsumers, egy nemzetközi fogyasztásváltozás-vizsgálat tapasztalatairól számolt be egy okosmérés kutatás bemutatásával. Konzorciumi vezetőként az Ariosz szakemberei a projekt során a fogyasztói szegmentációt végezték el, méghozzá metaklaszterezési eljárással. A cél az volt, hogy azonosítani tudják a tipikus fogyasztói mintázatokat, majd őket perszonalizált kommunikációval érjék el. Ez az újfajta koncepcionális megközelítés elsősorban a fogyasztói magatartásváltozás motiválását segíti elő: az automatizált, egyénre szabott üzenetek segítik elérni a fogyasztás csökkenést.

Kovács Gyula, az Andego Kft. ügyvezető partnere egy érdekes kutatásról beszélt, melynek során a fiktív cégeket modellezték adatbányászati és hálózati eszközökkel. A valós gazdasági tevékenységet nem végző vállalkozások kiszűrésének módszertanát bemutató prezentáció számos meghökkentő adattal és következtetéssel szolgált, miközben megismertük a céghalmozók vagy éppen a cégtemetők világát is. A kutatás részeként az irányított tanítás során vegyítették a prediktív- és iteratív modellt, így hoztak létre egy tanító adatbázist. A kiértékelés fázisában pedig felismerték a hagyományos kiértékelés korlátait, így új módszerek kerültek bemutatásra.

Dr. Lukács András, az ELTE Matematikai Intézet Számítógéptudományi Tanszék oktatója a deep learning, magyarul „mély tanulás” technológiáját mutatta be, mely az elmúlt pár évben észrevétlenül beszivárgott mindennapjainkba is. Hatalmas adatmennységek, nagy számítási kapacitások és kifinomult algoritmusok az összetevői azoknak a sikereknek, amelyeket számos mesterséges intelligencia körébe tartozó, korábban elérhetetlennek tűnő képesség, feladat egyre precízebb, megbízhatóbb megoldása adta. Önvezető autók, ipari robotok, beszéd felismerés és generálás, gépi fordítás, tárgyak és személyek képeken való beazonosítása, IT rendszerek felügyelete, sakk és go – pár példa egy folyamatosan bővülő listából. Az előadásban áttekintettük a deep learning technológia sajátosságait, és számos hasznos és/vagy érdekes alkalmazási példát ismerhettünk meg.

A Clementine vezető szakértője, Könyves Tóth Előd hosszú évtizedek óta foglalkozik az SPSS fejlesztésével, használatával, oktatásával és népszerűsítésével. Ennek okán hitelesen prezentálta az IBM szoftverének első 50 évét, humorral és számtalan háttér információval emlékezett meg a kezdetekről, a céggé válásról, vagy éppen az egyes korszakok legfontosabb érdekességeiről. A személyes élményekkel színezett rendhagyó SPSS történelem óra nem csak méltó megemlékezés volt a jubileum kapcsán, de színes zárása is volt a dataSTREAM konferenciának.

A csúcstalálkozó remek alkalom arra, hogy találkozzanak egymással a szakma különböző képviselői. A találkozón egyaránt megjelennek szakmai vezetők, elemzők és fejlesztők éppúgy, mint felhasználók és befektetők. Résztvevők a világ minden kontinenséről érkeznek, hogy megragadják a lehetőséget a kapcsolatépítésre, eszmecserére, inspirálódásra. Az idei volt a nyolcadik alkalom, hogy a csúcstalálkozót megrendezték, ennek megfelelően magas presztízs, kialakult résztvevői kör és kiváló előadások jellemezték a két nap programját. Az előadások két helyszínen összesen hat szekcióban zajlottak. Az első napot plenáris előadások nyitották meg, amelyeknek fő témája a mesterséges intelligencia kutatás és fejlesztés jövője volt. A két nap alatt közel 40 előadás járta körbe a nyelvtechnológia és kapcsolódó szakterületeinek legizgalmasabb szegmenseit, a felhasználói élmény valamint az ügyfél-elégedettség kiszolgálása mellett olyan területeket érintő fejlesztéseket is megismerhettünk, mint a biztonsági standardoknak való megfelelés a pénzügyi szektorban, a fordítói és tolmács szakma kapcsolata a nyelvtechnológiához vagy a mesterséges intelligencia szerepe az autógyártás jövőjében.

A csúcstalálkozó remek alkalom arra, hogy találkozzanak egymással a szakma különböző képviselői. A találkozón egyaránt megjelennek szakmai vezetők, elemzők és fejlesztők éppúgy, mint felhasználók és befektetők. Résztvevők a világ minden kontinenséről érkeznek, hogy megragadják a lehetőséget a kapcsolatépítésre, eszmecserére, inspirálódásra. Az idei volt a nyolcadik alkalom, hogy a csúcstalálkozót megrendezték, ennek megfelelően magas presztízs, kialakult résztvevői kör és kiváló előadások jellemezték a két nap programját. Az előadások két helyszínen összesen hat szekcióban zajlottak. Az első napot plenáris előadások nyitották meg, amelyeknek fő témája a mesterséges intelligencia kutatás és fejlesztés jövője volt. A két nap alatt közel 40 előadás járta körbe a nyelvtechnológia és kapcsolódó szakterületeinek legizgalmasabb szegmenseit, a felhasználói élmény valamint az ügyfél-elégedettség kiszolgálása mellett olyan területeket érintő fejlesztéseket is megismerhettünk, mint a biztonsági standardoknak való megfelelés a pénzügyi szektorban, a fordítói és tolmács szakma kapcsolata a nyelvtechnológiához vagy a mesterséges intelligencia szerepe az autógyártás jövőjében.